Meta a lancé les modèles Llama 3.2, une famille révolutionnaire de modèles de langage dotés de capacités améliorées, d'une applicabilité plus large et d'une prise en charge multimodale des images, désormais disponible dans Amazon Bedrock. Cette version représente une avancée significative dans le domaine des modèles de langage de grande taille (LLM), offrant des capacités améliorées et une applicabilité plus large à travers divers cas d'utilisation.

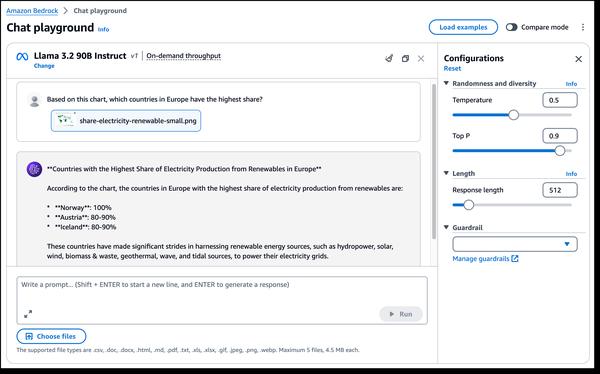

L'un des aspects les plus intéressants de Llama 3.2 est l'introduction de capacités de vision multimodales. Les nouveaux modèles 90B et 11B sont conçus pour la compréhension d'images et le raisonnement visuel, ouvrant de nouvelles possibilités pour des applications telles que la légende d'images, la récupération d'images et de texte, et les questions-réponses visuelles. Ces capacités pourraient révolutionner la façon dont nous interagissons avec les images et les utilisons dans différents domaines.

De plus, Llama 3.2 propose des modèles légers adaptés aux appareils en périphérie. Les modèles 1B et 3B sont conçus pour être économes en ressources avec une latence réduite et des performances améliorées, ce qui les rend idéaux pour les applications sur des appareils aux capacités limitées. Cela pourrait conduire au développement d'assistants d'écriture basés sur l'IA plus intelligents et d'applications de service client sur les appareils mobiles.

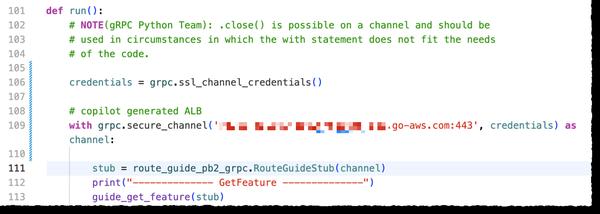

En outre, Llama 3.2 est construit sur Llama Stack, une interface standardisée pour la création de composants de chaîne d'outils canoniques et d'applications agentielles, ce qui rend la création et le déploiement plus faciles que jamais. Cela offre aux développeurs un moyen standardisé et efficace d'intégrer les modèles Llama dans leurs applications.

Dans l'ensemble, la sortie de Llama 3.2 marque une étape importante dans le domaine des modèles de langage de grande taille. Ses capacités améliorées et sa plus large applicabilité ouvrent de nouvelles possibilités pour un large éventail de cas d'utilisation, de la compréhension d'images et du raisonnement visuel aux applications en périphérie. Alors que la technologie de l'IA générative continue d'évoluer, nous pouvons nous attendre à d'autres innovations et applications transformatrices de la part de modèles tels que Llama 3.2.