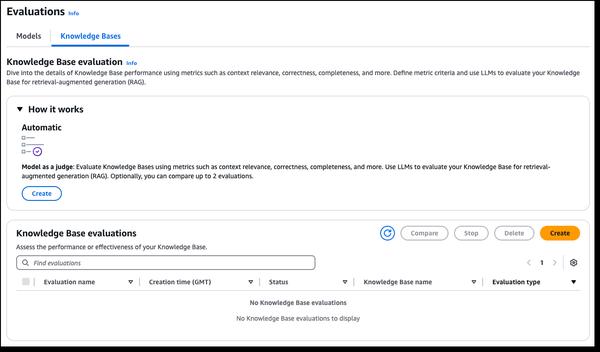

Amazon Bedrock a annoncé de nouvelles fonctionnalités d'évaluation RAG et LLM-as-a-judge, simplifiant les tests et l'amélioration des applications d'IA génératives. Les bases de connaissances Amazon Bedrock prennent désormais en charge l'évaluation RAG, vous permettant d'exécuter une évaluation automatique de la base de connaissances pour évaluer et optimiser les applications de génération augmentée par la récupération (RAG). Cela utilise un grand modèle linguistique (LLM) pour calculer les métriques d'évaluation, permettant la comparaison de différentes configurations et le réglage pour des résultats optimaux. L'évaluation du modèle Amazon Bedrock inclut désormais LLM-as-a-judge, permettant de tester et d'évaluer d'autres modèles avec une qualité quasi humaine à une fraction du coût et du temps. Ces fonctionnalités offrent une évaluation rapide et automatisée des applications d'IA, raccourcissant les boucles de rétroaction et accélérant les améliorations. Les évaluations évaluent les dimensions de qualité telles que l'exactitude, l'utilité et les critères d'IA responsable tels que le refus de réponse et la nocivité. Les résultats fournissent des explications en langage naturel pour chaque score, normalisé de 0 à 1 pour une interprétation facile. Les rubriques et les invites du juge sont publiées dans la documentation pour la transparence.

Nouvelles fonctionnalités d'évaluation RAG et LLM-as-a-judge dans Amazon Bedrock

AWS